RACHEL BARBARA HÄUBI

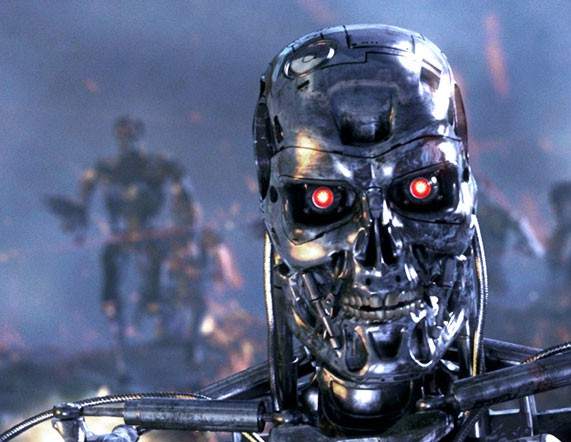

Los robots asesinos están en el campo de batalla y las organizaciones humanitarias se muestran preocupadas. Georgia Hinds, asesora jurídica del Comité Internacional de la Cruz Roja (CICR), subraya la necesidad urgente de contar con un tratado vinculante para, de aquí a 2026, prohibir y restringir las armas autónomas.

“Lavender”, el software de inteligencia artificial (IA) desarrollado por el Ejército israelí, identificó hasta 37.000 objetivos potenciales en GazaEnlace externo, según un reciente informe de prensa. El programa tenía un margen de error del 10 % y, como “daños colaterales”, permitía matar entre 15 y 300 civiles por cada objetivo de Hamás, dependiendo de su rango, tal y como reconocieron fuentes de los servicios de inteligencia israelíes.

Israel no es una excepción. La guerra, en todo el mundo, está evolucionando para hacerse más digital, rápida y automatizada. Hasta el punto de que a las personas solo les quedan unos segundos —o ninguno— para apretar el gatillo. En Ginebra, las Naciones Unidas y las organizaciones humanitarias temen que los crímenes de guerra relacionados con estas tecnologías —que evolucionan más rápidamente que su regulación— aumenten.

Con ocasión de la última conferencia de la ONU “AI for Good” [IA para el bien], celebrada en Ginebra los días 30 y 31 de mayo, SWI swissinfo.ch ha hablado con Georgia Hinds, asesora jurídica del CICR para nuevas tecnologías de guerra. A principios de mayo, Hinds publicó dos nuevos informes sobre el impacto de la IA en la toma de decisiones militares y sus implicaciones para las personas civiles, quienes combaten y la ley.

SWI swissinfo.ch: En la actualidad, ¿qué aplicaciones militares tiene la inteligencia artificial (IA)?

Georgia Hinds: La inteligencia artificial, cada vez más, se está integrando en el campo de batalla en al menos tres áreas clave. La primera, en las operaciones cibernéticas y de información, que modifican la naturaleza y la difusión de la información, utilizando, por ejemplo, la “tecnología deepfake” [que crea contenidos falsos] para fabricar contenidos muy realistas, aunque falsos. Otra aplicación clave es en los sistemas de armas, donde la IA se emplea para controlar parcial o totalmente funciones como la selección de objetivos o el lanzamiento de un ataque, como es el caso de los sistemas de armas autónomas (AWS, por sus siglas en inglés). Por último, la IA se está utilizando en herramientas de apoyo o información para tomar decisiones militares, modelando, por ejemplo, los efectos de un arma, pero también ahora para proporcionar recomendaciones más complejas sobre posibles objetivos o líneas de actuación.

Con una tecnología que evoluciona tan rápidamente, ¿la regulación puede seguir el ritmo?

Debemos tener en cuenta que la IA no se está desarrollando por sí sola. Quienes están eligiendo desarrollar esta tecnología son los seres humanos y los seres humanos siguen pudiendo elegir cuándo y cómo aplicarla en el campo de batalla.

El derecho internacional humanitario no regula explícitamente la IA militar ni las armas autónomas. Es, sin embargo, «tecnológicamente neutral»; lo que significa que sus normas se aplican al uso de cualquier arma o forma de llevar a cabo la guerra, por lo que en ese sentido no existe ningún vacío legal. Sea cual sea la tecnología utilizada, los mandos humanos siguen siendo responsables de garantizar que cualquier ataque respete los principios de distinción (apuntando solo contra combatientes u objetivos militares), proporcionalidad (evitando daños desproporcionados a civiles) y precaución (tomando todas las medidas factibles para evitar daños a civiles). Dicho esto, en lo que a las armas autónomas respecta, vemos una necesidad urgente de nuevas normas jurídicamente vinculantes que proporcionen más claridad y orientación sobre cómo se aplica el derecho internacional humanitario para prohibir determinadas armas autónomas y limitar el uso de otras. Este tipo de orientación es necesaria no solo para los ejércitos, sino también para la industria, para quienes las desarrollan, y para abordar las preocupaciones más generales que estas armas plantean, incluso desde perspectivas humanitarias, éticas y de seguridad.

¿Qué medidas deberían adoptarse para regular los sistemas de armas autónomas?

El CICR define las armas autónomas como sistemas que, sin intervención humana, seleccionan y aplican la fuerza a objetivos. Hemos pedido un nuevo tratado vinculante, que deberá concluirse antes de 2026, para prohibir ciertas armas autónomas e imponer restricciones estrictas al diseño y uso de todas las demás. Estas normas deben prohibir, en particular, las armas autónomas impredecibles (cuyos efectos no pueden controlarse, como cuando, por ejemplo, las máquinas “aprenden” por sí solas) y las que directamente apuntan a las personas. Se necesita con urgencia este tipo de normativa para preservar el control humano sobre el uso de la fuerza en los conflictos armados y, de este modo, limitar los efectos de la guerra y mantener la protección fundamental no solo para los civiles, sino también para los combatientes.

El secretario general de la ONU y el presidente del CICR en 2023 instaron a los Estados a ultimar un instrumento jurídicamente vinculante para prohibir, antes de 2026, las armas autónomas letales. La Asamblea General de la ONU desde entonces ha adoptado una resolución que expresa su preocupación por el riesgo de las armas autónomas. ¿Cuáles son los siguientes pasos?

Basado en las opiniones de los Estados, pero también de organizaciones internacionales y regionales como el CICR, la sociedad civil, la comunidad científica y la industria, en los próximos meses, el secretario general de la ONU elaborará un informe de fondo sobre las armas autónomas. Corresponderá a la comunidad internacional actuar sobre la base de las recomendaciones de ese informe. Instamos a los Estados a que inicien las negociaciones de un instrumento jurídicamente vinculante para garantizar que las protecciones fundamentales puedan preservarse para las generaciones futuras. Durante más de una década, las distintas organizaciones de Ginebra han debatido los riesgos y retos que las armas autónomas plantean en el contexto de la Convención de la ONU sobre ciertas armas convencionales, que pretende prohibir o restringir el uso de armas cuyos efectos se consideren excesivamente nocivos o indiscriminados. Ahora contamos con una clara mayoría de Estados a favor de normas jurídicamente vinculantes, por lo que somos optimistas de que este impulso pueda producir un tratado efectivo para 2026.

En Ginebra se ha celebrado la Cumbre “AI for Good” [IA para el bien]. ¿Puede utilizarse la inteligencia artificial para evitar daños a civiles durante la guerra y, por tanto, cumplir mejor el derecho humanitario?

Es importante examinar críticamente cualquier afirmación de que las nuevas tecnologías harán que la guerra, de algún modo, sea más humana. Hemos escuchado afirmaciones similares antes, en el contexto de las armas químicas, por ejemplo, y también de los drones; y, sin embargo, seguimos viendo sufrimiento a gran escala y civiles atrapados en los conflictos. Para dotar a la guerra de mayor humanidad es necesario dar prioridad al cumplimiento del derecho internacional humanitario, con el objetivo específico de proteger a las personas civiles. Reconocemos que, a quienes toman las decisiones, algunos sistemas de IA pueden ayudarles a cumplir la ley, en la guerra urbana, por ejemplo, si pueden proporcionar a los comandantes información adicional sobre factores como las infraestructuras civiles y la población. Los responsables de la toma de decisiones, al mismo tiempo, deben comprender y tener en cuenta las limitaciones de estas tecnologías, como las importantes lagunas de datos, los sesgos y la imprevisibilidad.

Según una investigación de periodistas de Jerusalén, el Ejército israelí ha desplegado en Gaza un sofisticado sistema de IA para atacar a presuntos dirigentes de Hamás. El programa, en algunos casos, tolera márgenes de error de hasta 100 civiles fallecidos por objetivo, de acuerdo con los informes. ¿Qué opina al respecto? ¿Cómo podemos exigir responsabilidades a los países cuando no existe ninguna ley?

El CICR es una organización humanitaria neutral e imparcial, por lo que generalmente nos abstenemos de comentar públicamente sobre usos y situaciones específicas en conflictos en curso; son cuestiones que forman parte de nuestro diálogo confidencial y bilateral.

Sin embargo, como he mencionado antes, en los conflictos armados no existe ningún espacio o situación sin ley. Independientemente de las herramientas que se utilicen, el derecho internacional humanitario y los marcos para la rendición de cuentas seguirán aplicándose. Para aplicar estas normas a un ataque en el que un ejército haya utilizado un sistema de IA, podríamos examinar si ha sido razonable que un comandante confiara en los resultados de un sistema de IA y si se tomaron todas las precauciones posibles para evitar daños a civiles.

¿Está perdiendo la humanidad el control sobre sus armas?

En el contexto de los sistemas de armas autónomos, la pérdida del control humano sobre los efectos de los sistemas de armas es una de nuestras principales preocupaciones, especialmente a medida que vemos tendencias hacia sistemas cada vez más complejos, con parámetros de funcionamiento cada vez más amplios. Dicho esto, nuestra evaluación es que las fuerzas militares siguen manteniendo el pilotaje o la supervisión a distancia de los sistemas de armas, incluso cuando ciertas armas —como los drones armados— se anuncian como capaces de funcionar de forma autónoma. Para asegurarse de que se preserva este control sobre el uso de la fuerza, ahora es clave establecer límites claros al diseño y uso de armas autónomas.

En 2030, los soldados robot podrían constituir una cuarta parte del Ejército británico. En su opinión, ¿cuál es el futuro de la guerra?

Lamentablemente, con independencia de la tecnología que se utilice, el futuro de la guerra es horrible. A veces, cuando se habla de nuevas tecnologías, esta realidad se pierde, ya que estos debates se producen lejos del campo de batalla, y, de alguna manera, las nuevas tecnologías se presentan como limpias o clínicas.

Nuestra lectura es que las tecnologías robóticas físicas progresan más lentamente que los avances en IA. Los avances menos visibles de la IA plantean preocupaciones inmediatas, y no cabe duda de que acabarán permitiendo desarrollar nuevos sistemas robóticos.

A corto plazo, vemos que la integración de la IA en el campo de batalla será un elemento clave, no solo en los sistemas de armas, sino en todo el ciclo de planificación y toma de decisiones, desde hacer recomendaciones hasta controlar aspectos de los sistemas de armas durante los ataques. Así pues, la guerra del futuro cada vez será más compleja e impredecible. Nuestra prioridad, por tanto, es centrar la atención de la comunidad internacional en las aplicaciones específicas de la IA en los conflictos armados que suponen un mayor riesgo para la vida y la dignidad de las personas.

Texto adaptado del ingles por Lupe Calvo / Carla Wolff

Descubre más desde Notiultimas

Suscríbete y recibe las últimas entradas en tu correo electrónico.